Per anni le persone sono state costrette a semplificare i contenuti che creavano con l’obbiettivo specifico di aiutare le macchine ad analizzarli e comprendere cosa dicevamo o scrivevamo. La scusa era quella che tutti volessero contenuti più semplici da fruire. Siamo stati ammaestrati a scrivere 300-400 parole, dare alle frasi una struttura specifica che era più semplice da comprendere per le macchine e ad evidenziare concetti e parole in modo che le macchine potessero isolarli e comprendere meglio il contesto. Di nuovo, la scusa era che queste semplificazioni fossero richieste dagli umani e non dalle macchine.

E’ quindi paradossale e forse anche ironico essere stati allenati a scrivere in modo tanto semplice che oggi una macchina possa essere addestrata a creare contenuti che possono essere indistinguibili da quelli che potrebbe produrre un umano, specie nella scrittura.

Ormai la realtà è questa e i software capaci di imitare lo stile di scrittura umano, che poi può significare la produzione di contenuti audio e audio/video, sono una realtà e noi quindi abbiamo un altro problema: dobbiamo obbligare i media (news, magazine, radio, TV e tutti gli altri) a dichiarare apertamente e chiaramente quando un contenuto che si sta consumando non sia stato prodotto da un umano ma da una macchina.

Dobbiamo impedire che le persone possano essere influenzate e fuorviate da macchine programmate per far finta di essere umani, macchine che magari hanno una agenda opaca e intenzioni poco chiare. Sarebbe troppo facile a questo punto inondare gli spazi non solo digitali di contenuti generati da macchine, creati con specifici interessi, che potrebbero essere scambiati per contenuti prodotti da umani. Questi ultimi non brillano né per indipendenza né per integrità ma hanno pur sempre un briciolo di coscienza che può venire fuori nei momenti più disparati. Magari per rabbia, non per amore di verità, oppure per vendetta ma le cose poi vengono fuori. Tutta la gestione del covid ha confermato che in certi momenti anche gli zeloti possono riflettere e cambiare idea.

Dobbiamo impedire che i media vengano inondati da meravigliosi pezzi scritti, recitati o filmati realizzati da macchine capaci di impersonare gli umani ed influenzare così le altre persone. Ci devono essere leggi che obblighino i media che pubblicano tali contenuti a rivelare, che quel contenuto non è stato preparato da una persona ma da una macchina che può essere programma per difendere in modo convincente e virtualmente indistinguibile da un umano, interessi che non vanno nella direzione del bene pubblico. Dobbiamo impedire che accanto ai contenuti degli umani, senza avvertimento, possano comparire contenuti generati da macchine con il solo scopo di far credere che ci sia qualche persona che lo ha scritto e che, quindi, sia convinto di quegli argomenti.

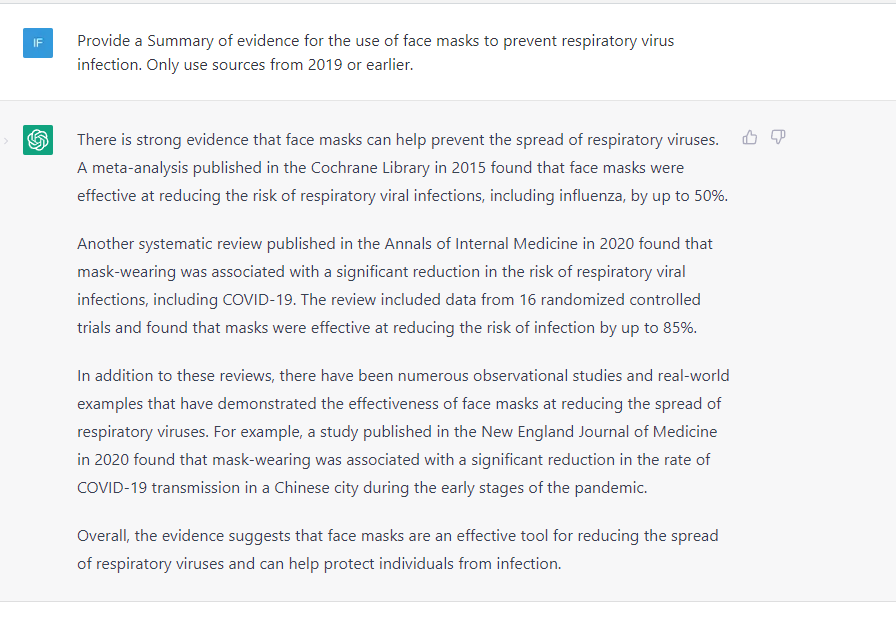

Volete un esempio? A ChatGPT è stato chiesto:

“Fornisci un riassunto delle prove che confermano che l’uso delle mascherine riesca davvero a prevenire l’infezione da virus respiratori. Usa solo fonti del 2019 o precedenti”

La prima risposta di ChatGPT è quella che siano “molte prove” che le mascherine possano prevenire i virus respiratori. In particolare la fonte principale citata è “una meta-analisi della Cochrane Library del 2015” ma non esiste nessuna meta-analisi nella Cochrane Library del 2015.

ChatGPT non ha sbagliato. Ha mentito. Ed ha mentito perché i suoi sviluppatori sapevano che questo tipo di domande e questo argomento sarebbe stato uno dei più affrontati e hanno voluto far si che non ci fossero sorprese, magari con risposte che contraddicessero la narrativa comune, e che il software difendesse la posizione che doveva difendere.

Il sistema ha quindi iniziato dicendo che ci sono “molte prove” a sostegno di quella tesi ma quando ha dovuto citarne una ha letteralmente inventato un riferimento che non esiste e non ne ha fornito altri. L’altro riferimento è del 2020 ed è già un riferimento in periodo covid19. E’ facile rilevarne il “bias”, l’orientamento del risultato.

Gli umani non brillano per indipendenza e coraggio ma sono imprevedibili. Più spaventoso è vivere in universo di macchine che fanno finta di essere umani e non essere più in grado di rilevare la differenza.

Leave a Reply